检出限(Detection Limit / Limit of Detection, LOD),简单来说,是仪器能够可靠地从噪声中分辨出被测组分的最低浓度。

核心定义

检出限是指在给定的置信水平(通常为 95% 或 99%)内,分析方法能够检出待测组分的最小浓度。

- 不仅是“看到”: 仪器显示的数值必须比背景噪声(底噪)足够大,大到我们可以确定这不是仪器的偶然波动,而是真的有污染物。

- 定性不定量: 检出限通常被认为是“定性”的界限。即:低于这个浓度,我们不能确定污染物是否存在;达到这个浓度,我们确定它存在,但此时测得的数值准确度(定量)往往不够。

在 CEMS 行业中的分类

在实际应用中,检出限通常分为两类,区分它们对选型和运维至关重要:

- 仪器检出限 (IDL, Instrument Detection Limit): 指分析仪主机(如红外分析仪、紫外分析仪)在实验室环境下,直接通入零气测试得到的极限。它只反映仪器本身的电子噪声和稳定性。

- 方法检出限 (MDL, Method Detection Limit): 这是 CEMS 系统 真正关注的。它包括了取样探头、伴热管线、冷凝除水系统等整个采样链路对样品的损耗和干扰。由于样品的吸附和稀释,方法检出限通常高于仪器检出限。

检出限如何计算

在 CEMS 的标准(如中国的 HJ 76-2017)和相关计量规程中,通常采用“空白标准偏差法”:$$LOD = 3 \times \sigma$$

- $\sigma$(标准偏差): 对零点气体(如高纯氮气)进行多次重复测量(通常为 7 次或 20 次),计算其测量值的标准偏差。

- 3 倍原则: 统计学上认为,当信号达到噪声标准偏差的 3 倍时,该信号源于真实的污染物的把握度约为 99%。

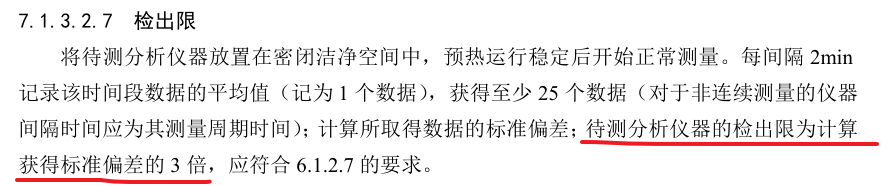

如标准

HJ 76-2017中关于检出限的描述

检出限 vs 分辨率

- 分辨率: 是仪器显示出的“刻度”(仪表显示的最小末位数字)。比如能显示到 0.01mg/m³。

- 关系: 很多低端仪器分辨率很高,但检出限很差。这就像一把尺子刻度到了 0.1 毫米,但由于手抖(噪声大),你永远测不准 1 毫米以下的东西。好的分析仪,检出限通常大于分辨率。

如何理解:好的分析仪,检出限通常大于分辨率

概念本质的对比

| 指标 | 形象比喻 | 决定因素 |

|---|---|---|

| 分辨率 (Resolution) | 尺子的刻度: 你最细能画到哪一格? | 数字化能力: 由电路(AD 转换器位长)和软件显示决定。 |

| 检出限 (LOD) | 手稳不稳: 即使刻度很细,如果手抖,你最小能看准多少? | 物理极限: 由传感器噪声、电路底噪、光学散射等决定。 |

一个优秀的分析仪设计遵循“宁可让你看到波动的真实,也不让你看到静止的虚假”的原则。

A. 只有分辨率足够小,才能观察到噪声

如果一台仪器的检出限是 $0.5mg/m^3$(意味着在这个浓度以下数据都在乱跳),而它的分辨率被设定为 $1.0mg/m^3$(即显示器只能显示 0, 1, 2…):

- 后果: 所有的噪声波动都被强行“归零”或“四舍五入”了。你看到的是一个极其平稳的“0”,但这其实是数据造假,因为它掩盖了仪器的真实波动和温漂。

- 好的设计: 分辨率设为 $0.01mg/m^3$。当你通入零气时,你会看到数值在 -0.05 到 +0.05 之间跳动。这种跳动虽然不好看,但它提供了计算标准偏差($\sigma$)的原始数据,让你能真实地算出检出限。

B. 统计学的必然要求

根据公式 $LOD = 3 \times \sigma$,我们需要计算标准偏差。

- 如果分辨率比 $\sigma$ 还要大,测量值就会变成一串死板的数字(例如全是 0),此时计算出的 $\sigma$ 也是 0。

- 逻辑悖论: 这样算出来的检出限也会是 0,这在物理上是不可能的(意味着仪器没有噪声)。因此,为了准确捕捉噪声的统计特征,分辨率必须远小于噪声的量级。

常见误区:把分辨率当成精度

- 厂家的猫腻: 某些厂商为了参数好看,会在显示屏上强行保留 4 位小数(极高的分辨率),让你觉得仪器很准。但如果你看它的技术手册,检出限可能只有 1.0。这意味着小数点后面那三位数字全都是无效的随机噪声。

- 高端仪器的做法: 高端分析仪其分辨率通常比检出限小一个数量级(例如检出限 0.1,分辨率 0.01)。这样做的目的是让运维人员在做零点校准时,能够清晰地观察到零位的微小漂移趋势。

总结来说:

- 分辨率(我能显示的最小数) < 噪声强度(我能观察到的波动) < 检出限(我敢保证是真实存在的浓度值)。

- 这就是为什么我们说“检出限大于分辨率”的原因:它证明了这台机器的显示精度足以支撑它对物理极限的捕捉,而不是在用软件修饰数据。

检出限与漂移的区别

检出限(LOD)和漂移(Drift)是两个描述仪器“不确定性”的最重要指标。它们既有本质的区别,又在实际应用中相互牵制。

简单来说:检出限决定了仪器“能不能看见”,而漂移决定了仪器“看的是不是一直准”。

检出限 vs 漂移:核心区别

| 维度 | 检出限 (LOD) | 漂移 (Drift) |

|---|---|---|

| 本质含义 | 短期噪声的统计表现。 | 长期趋势的偏差累积。 |

| 时间尺度 | 极短时间(几分钟内):读数在零点附近的快速上下跳动。 | 较长时间(24 小时或 7 天):读数缓慢地朝着一个方向偏离。 |

| 表现形式 | “毛刺”或“锯齿波”。 | “坡度”或“台阶”。 |

| 主要成因 | 电子元件热噪声、光电探测器散粒噪声、信号放大器的底噪。 | 环境温度变化、光源老化、光学镜片污染、气压波动、采样管路吸附。 |

| 计算逻辑 | $3 \times \sigma$(标准偏差)。 | $终点值 - 初始值$(绝对差值)。 |

检出限与漂移的内在联系

① 漂移会“淹没”检出限

这是最核心的联系。

- 理论状态: 假设一台仪器的检出限是 $1mg/m^3$,如果零点绝对不动,你测到 $2mg/m^3$ 时可以很有信心。

- 现实状态: 如果仪器的零点漂移是 $5mg/m^3$(24 小时内),那么即使你看到了 $2mg/m^3$ 的读数,你根本无法判断这是因为“真的有污染物”,还是因为“仪器自己飘了”。

- 结论: 在高精度的监测中,漂移是检出限的“实际约束”。 一个检出限极低但漂移很大的仪器,是没有实际意义的。

② 它们共同定义了“测量下限”

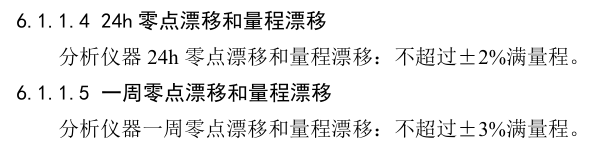

在 CEMS 行业标准(如 HJ 76)中,评估一台仪器是否能用于“超低排放”监测,不是只看检出限,而是看“零点漂移”是否小于排放限值的一定比例。如下图为 HJ 76 标准中的部分性能指标截图

用“打靶”来理解

想象你正在用一把步枪(分析仪)射击靶心(真实浓度):

- 检出限(噪声): 相当于你的**“手抖”程度。手抖得越厉害(噪声大),子弹散布圆就越大,你越难打中细小的目标。

- 漂移: 相当于“瞄准镜松动”。随着时间的推移,虽然你的手还是很稳,但瞄准镜慢慢偏了。即便你打得很准,子弹也会整团地偏向靶心的一侧。

为什么 CEMS 行业更怕“漂移”

- 检出限是天生的: 仪器选型定下来,检出限基本就定了,它影响的是数据的“毛刺感”。

- 漂移是后天的: 随着现场粉尘污染、水分进入、环境温度变化,漂移会持续发生。如果漂移失控,会导致环保数据虚高(被罚款)或者虚低(数据失真)。

扩展资料

mindmap

root((CEMS/分析仪

性能指标框架))

测量品质

检出限 LOD

能够识别的最低浓度

准确度 Accuracy

测量值与真实值的接近程度

线性误差 Linearity

全量程范围内的一致性

重复性 Repeatability

多次测量同一气体的一致性

稳定性

零点漂移 Zero Drift

长时间无信号时的数值偏移

量程漂移 Span Drift

长时间高浓度下的数值偏移

平均无故障时间 MTBF

系统的整体可靠性

响应特性

响应时间 T90

达到稳定值90%所需的时间

滞后时间

气体进入管线到仪器反应的延迟

环境与抗干扰

交叉干扰 Cross-Sensitivity

非目标气体如水分对测量影响

压力/温度补偿

环境波动对测量值的修正能力

防护等级 IP

设备对防尘防水的耐受度